DeepSeek 本地部署教程(极其简单)

DeepSeek 本地部署教程

DeepSeek-R1模型在各项指标直逼甚至超越OpenAI及同类产品,迅速成为业界焦点。更令人惊喜的是该模型基于MIT协议免费开源,允许任何公司或个人自由商用,无需任何授权限制,一时间在AI界掀起了巨大波澜。

最近DeepSeek服务被外海攻击,有时候无法访问,既然DeepSeek-R1是开源的,那么我们其实可以部署自己的DeepSeek-R1模型,如果再结合Webman AI,效果将更加完美。

废话不多说,直接上教程教怎么本地部署DeepSeek-R1服务。

前提

电脑有显卡,显卡越好效果越好

一、安装ollama

二、根据配置安装合适的版本

| 参考量 | 显存需求 | 显卡推荐 | 命令 |

|---|---|---|---|

| 1.5B | 通常4GB左右 | GTX 1050 | ollama run deepseek-r1:1.5b |

| 8B | 一般8-10GB | GTX 1660 | ollama run deepseek-r1:8b |

| 14B | 12GB以上,16GB以上运行流畅 | RTX 3060 | ollama run deepseek-r1:14b |

| 32B | 16GB以上,21GB以上运行流畅 | RTX 3060 | ollama run deepseek-r1:32b |

| 70B | 24GB以上,40GB以上运行流畅 | RTX 3090、RTX 4090 | ollama run deepseek-r1:70b |

| 671B | 1342GB | 16张NVIDIA A100 80GB显卡 | ollama run deepseek-r1:671b |

根据显存选择合适的版本,有条件的建议上32B或者70B,效果非常好。

如果显存不够,并且使用了高版本,会自动使用CPU+显存的方式来运行,但是输出很慢,每秒1-2个字。

三、对话

安装完之后就可以直接在命令行对话了。

以下内容为可选项

配合 Webman AI (可选)

如果你有 Webman AI 程序,则可以接入自己的 deepseek-r1,提升用户体验的同时,使自己从中获取收益。

ollama 默认在命令行中对话,UI界面并不友好,如果配合 Webman AI 也可以有更好的交互体验。

假设你已经部署了Webman AI程序,通过以下步骤接入 DeepSeek-R1。

进入到Webman AI 管理后台

-

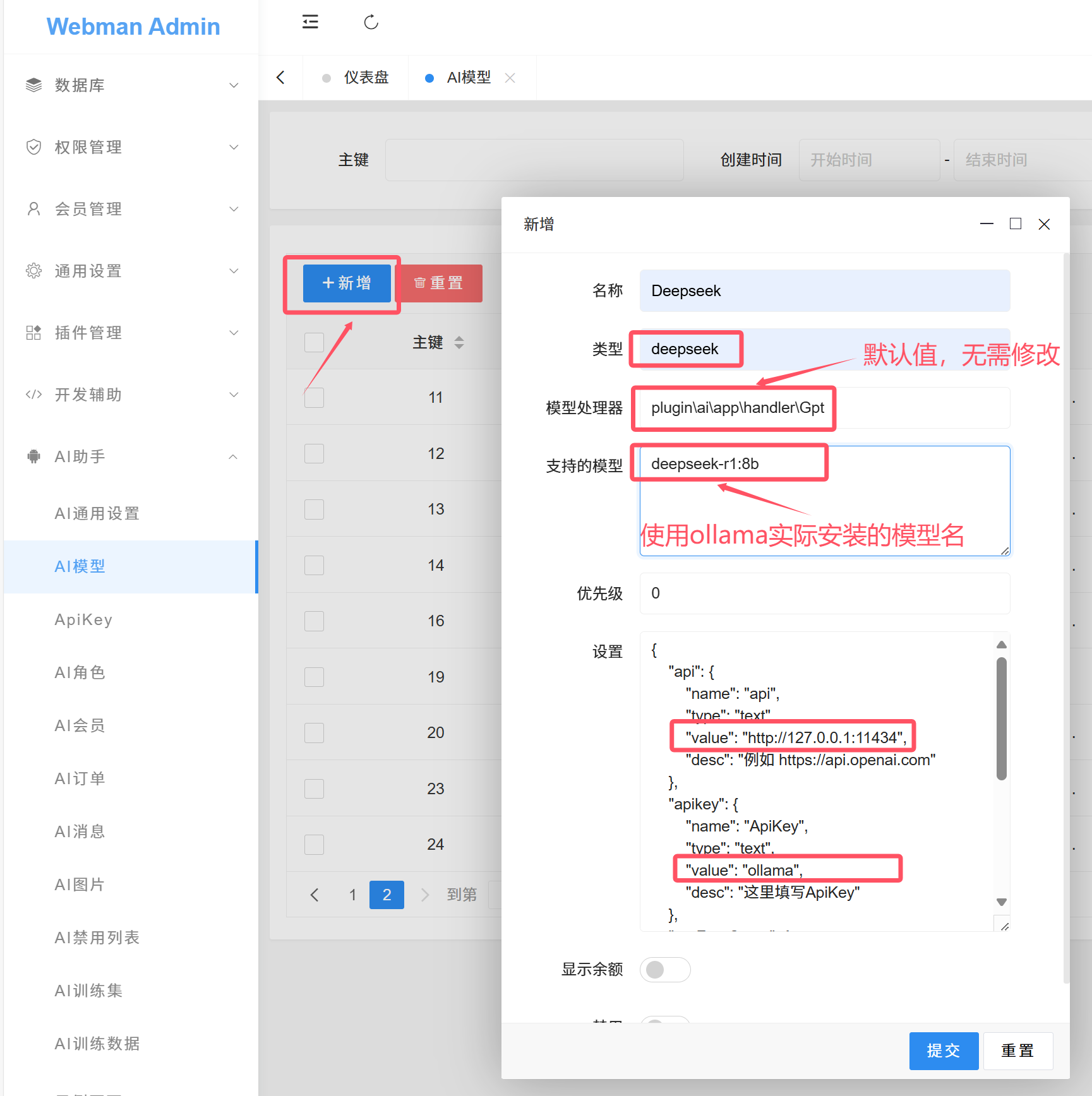

新增模型

-

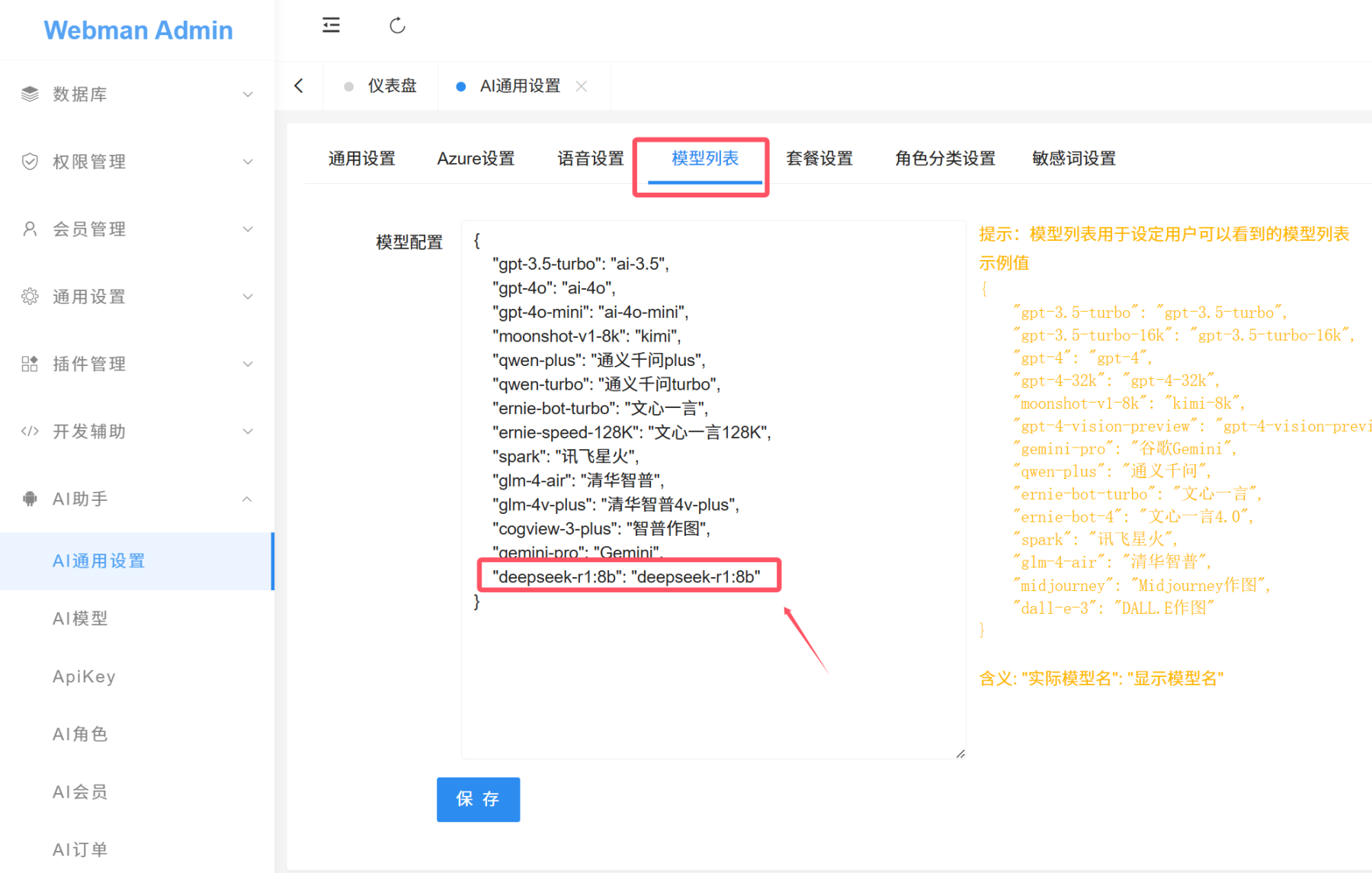

设置对外模型名称

-

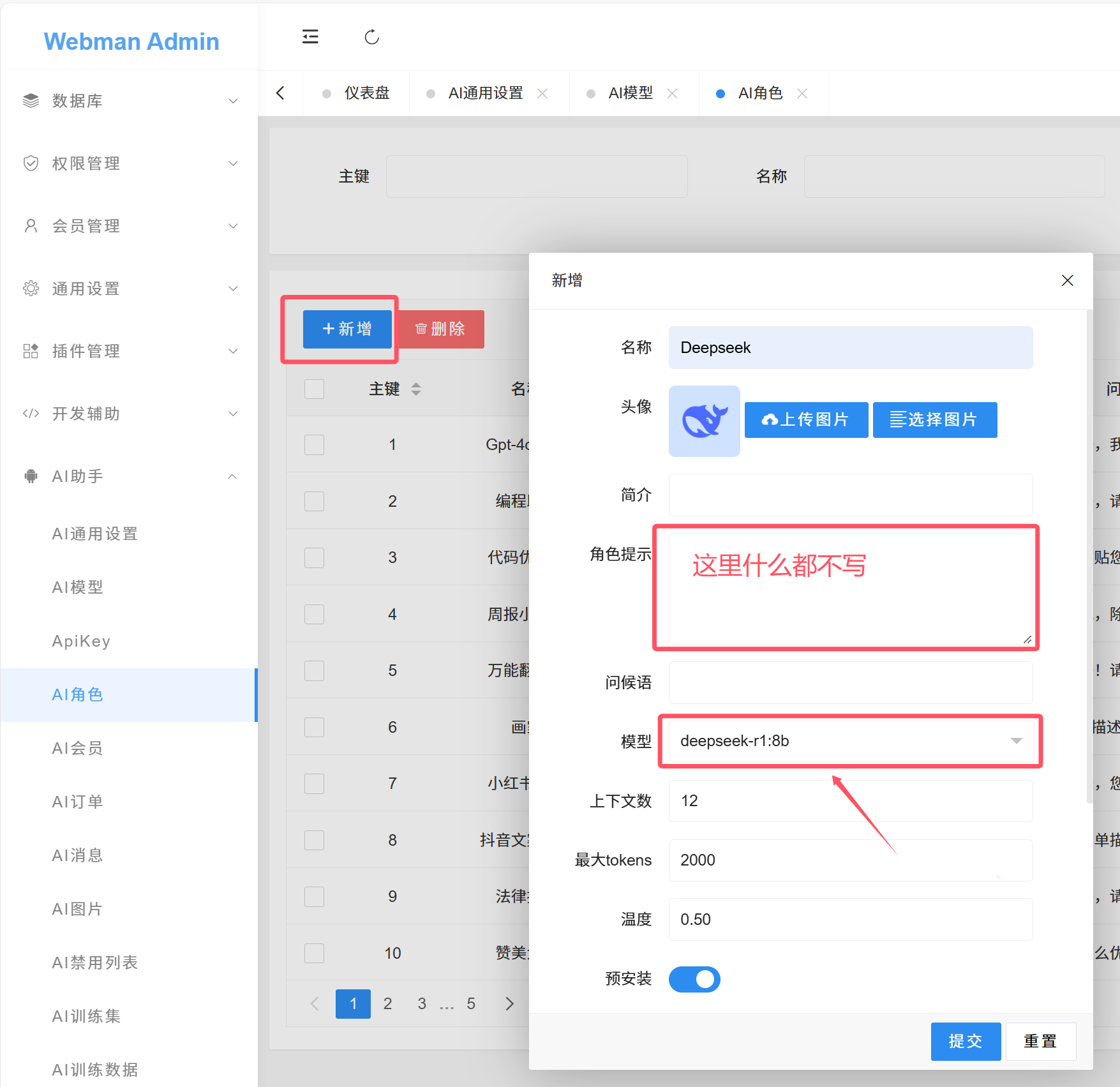

新建角色

-

测试

4680 9 14

9个回答

相似问题

月贡献榜

赞助商

热门问答

DeepSeek 本地部署教程(极其简单)

illuminate/database越来越臃肿,有考虑过自己出个orm么?

大家是怎么解决手机号、身份证号这类数据的加密存储

🤖 Webman AI接入DeepSeek教程 [赠送50¥+ 20$额度]

workerman发布v5版本

文档中的支付宝SDK问题yansongda/pay

【已解决】写安装引导时很奇怪的502或无响应问题,CPU占用会高

高并发场景下mysql连接连接数过多

用官方提供的php8.4运行webman,登录时获取不到图片验证码

求助大佬,PHP可执行文件,如何查看php.ini

挺好的

mark

good

感谢老大分享

帅气

点赞

接入竟然这么简单,大佬V5

如何训练自已的知识库呢?

https://www.workerman.net/doc/ai/install/embedding.html

训练方式一样,回答问题时可以选择用deepseek回答

请教下老大:

1、向量的那个啥算法是自研的还是调用哪个的呀?

2、上传的文档目前只能是 .txt与.md的吗?比如:docx与ppt能支持吗后面?

3、webman/ai与deepseek一起离线部署在局域网(不联网)可以训练知识库使用吗?

能关联知识库吗

可以关联

关联不是还要设置角色提示吗? 我看角色提示那为空 是不能填吗

deepseek-r1 不支持角色提示,deepseek-chat可以设置。

好的