🤖 Webman AI接入DeepSeek教程 [赠送50¥+ 20$额度]

最近DeepSeek超级火爆,很多开发者问起Webman Ai如何接入DeepSeek,今天图文教程来了,非常简单,只需要三步即可。

其他平台满血DeepSeek-R1

因为DeepSeek官方负载较大,接口返回很慢失败率很高,这里推荐几个流畅的DeepSeek-R1满血平台。

通过邀请码注册的还赠送一些额度。

Novita AI 此连接赠送20美元

派欧算力云 此连接赠送 5¥+50¥额度

硅基流动 此连接赠送14¥

接入步骤

-

进入管理后台

http://example.com/app/admin -

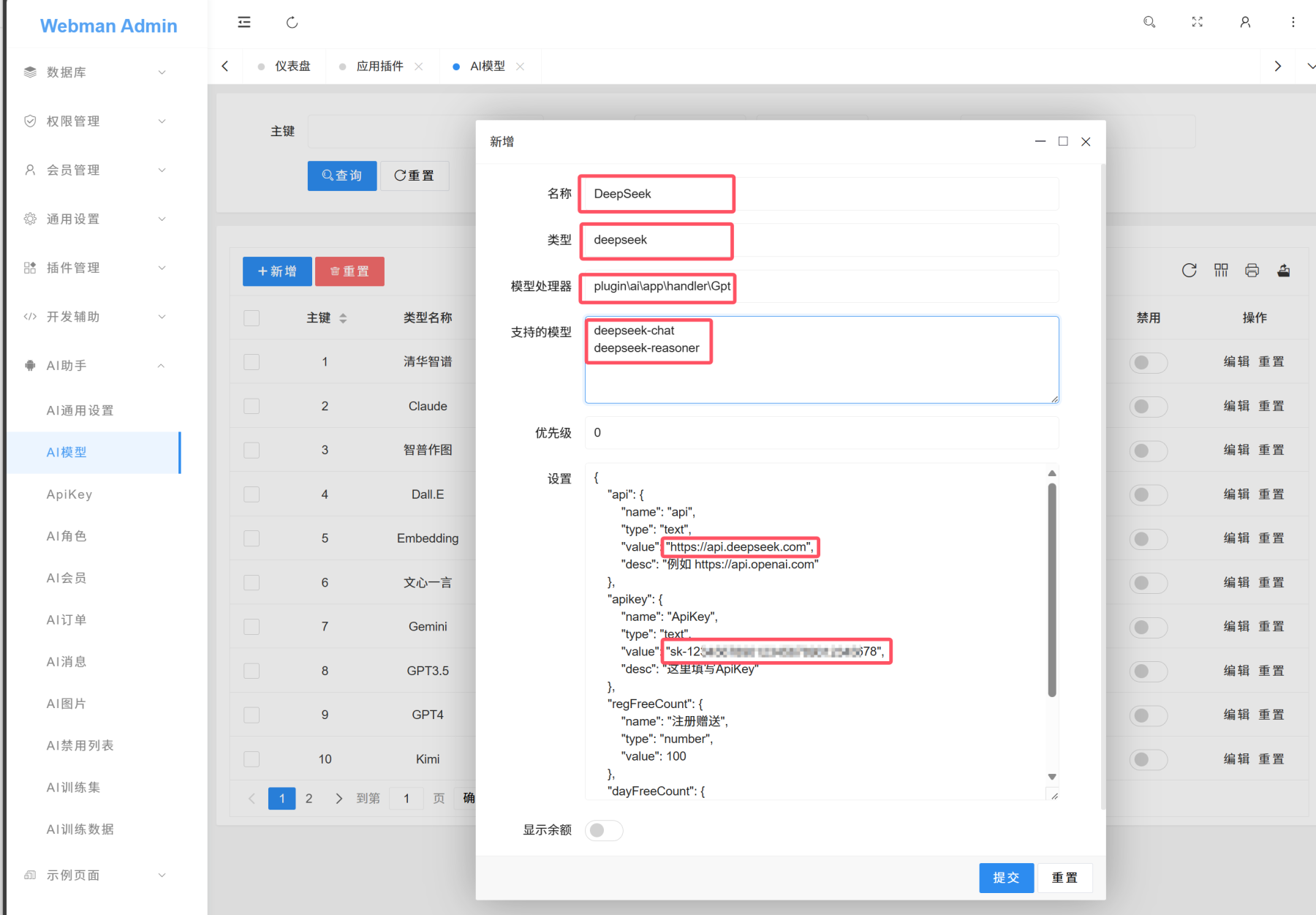

AI模型里添加如图模型

名称:DeepSeek

类型:deepseek

模型处理器:plugin\ai\app\handler\Gpt(plus版默认值) plugin\gpt\app\handler\Gpt(基础版默认值)

支持的模型:

deepseek-chat

deepseek-reasonerapi:https://api.deepseek.com (DeepSeek官方地址,如果是其它平台地址有所不同)

apikey:sk-xxxx DeepSeek官方apikey获取地址

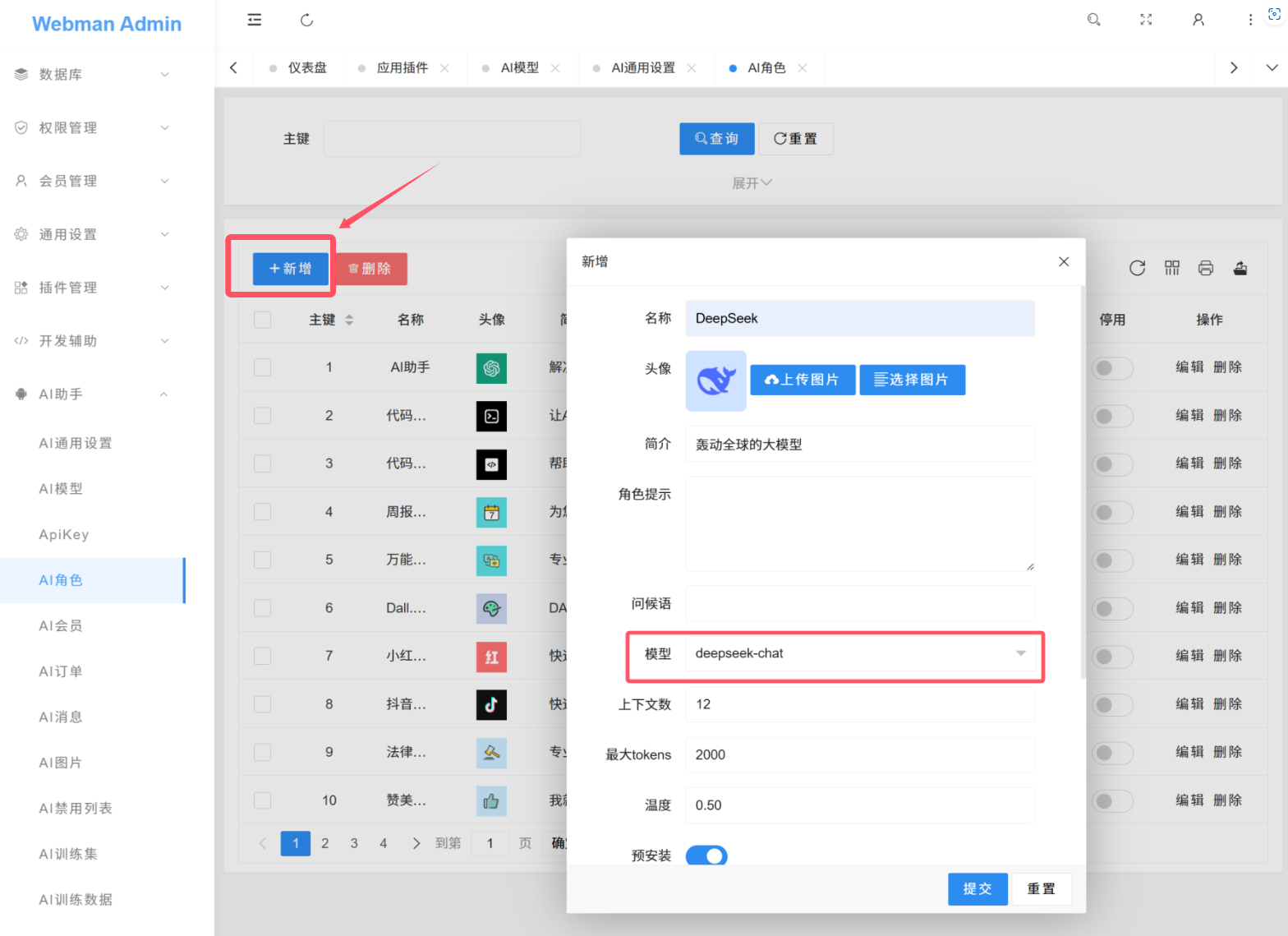

- 配置对外的模型列表

"deepseek-chat": "deepseek-chat",

"deepseek-reasoner": "deepseek-reasoner"- 新增角色

注意

deepseek-reasoner 不支持设置角色提示词。

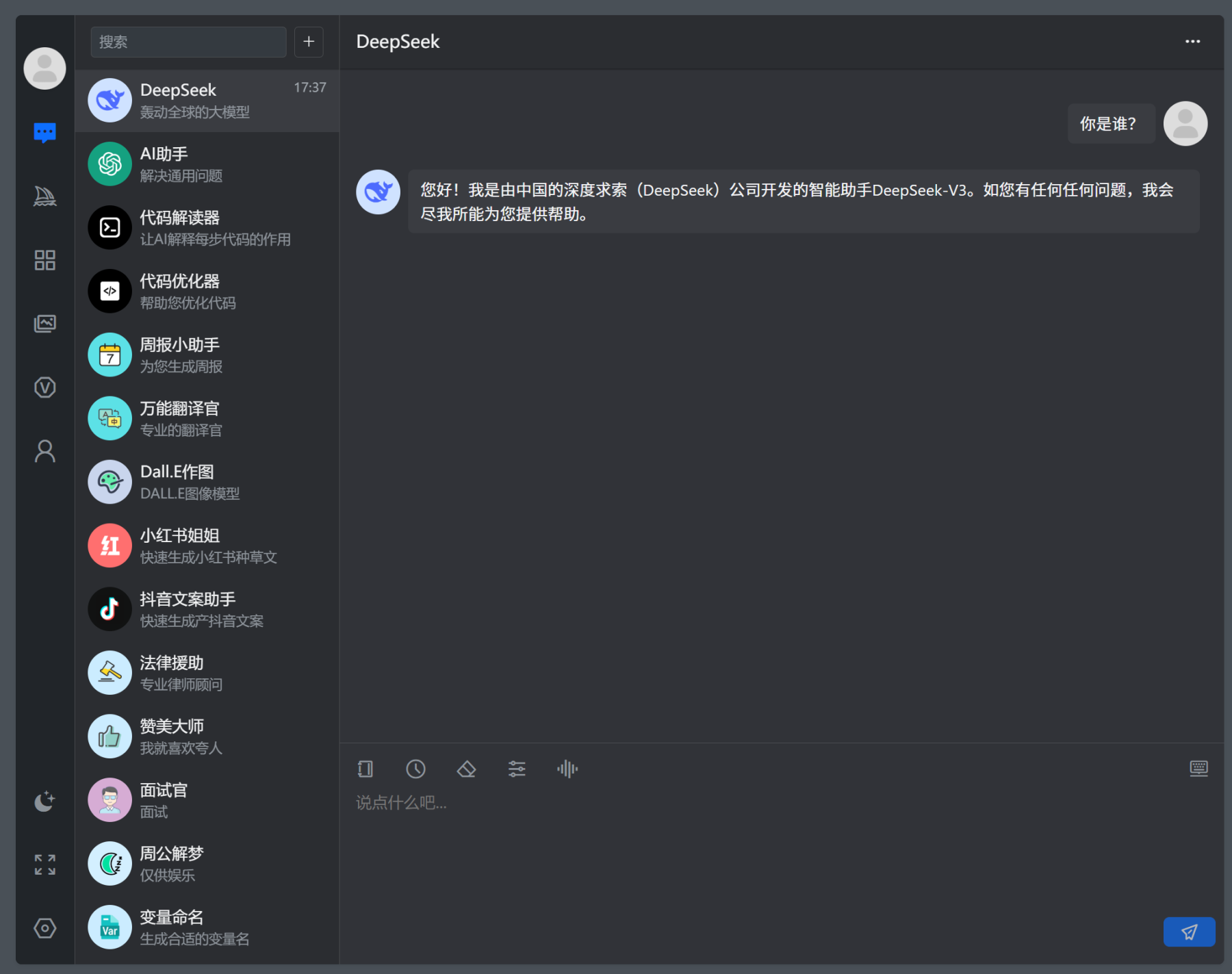

- 前端访问

其它相关连接

如果你本地有大显存显卡,也可以本地部署DeepSeek,参见 DeepSeek本地部署教程

2452 9 8

9个回答

相似问题

赞助商

热门问答

DeepSeek 本地部署教程(极其简单)

🤖 Webman AI接入DeepSeek教程 [赠送50¥+ 20$额度]

workerman发布v5版本

webman新版本Request没有每次请求都是新的

yansongda/pay 和 easywechat 哪个对 webman 支持的更好?

使用 setGet 修改了参数, 参数是拼接上去的, 频繁访问的话, 参数会一直拼接

webman-framework 发布1.6.0版本

使用webman2.1后,一段时间CPU飙升,没有处理任何请求。(已解决,swow导致,不使用别用)

有偿求教:微信支付 容器异常: Target

宝塔安装的进程管理器重启服务,监听的端口下的进程数量会增加

支持大佬

您好,我这边调用本地搭建的DeepSeek模型,流式输出的时候,返回的数据带0就会返回一个空数据,比如我提问100以内素数之和,回答中没有0,求大佬解答

截个图吧,什么样的提问,哪里输出了空数据

下面是Driver下的文件

使用非流式返回的时候不会出现这个问题

你这里写的可能有问题,

改成

好的!感谢老大!犯了个低级的错误(面壁思过)

不客气,你们本地部署的具体哪个模型?用的服务器配置是怎样的?

我想本地部署试下,不知道需要什么配置。

本地是用的ollama,两个4070tisuper16g 可以跑32b和32b以下的,70b就很慢,一个字一个字往外蹦的那种(还是显存太小了)70b预计是需要至少32g以上的显存。

部署deepseek主要是吃显存,见过有大佬用魔改的多个2080ti22g部署,这个没有尝试过,不知道可不可行

https://www.bilibili.com/opus/1028826816959217669

好的,非常感谢

openwebui 这个是ollama的可视化界面

显存配置基本可以参考一下ollama上面的r1模型对应的大小,例如70b是40G左右,就是大概需要40g显存

32b是20G左右

大体可以这样推算

附一张图参考

大佬,支持思考过程好像需要改一下代码是不?

是,思考过程参数是reasoning_content,GPT的Driver默认只拿了content,这块需要特殊处理一下(或者干脆自己复制粘贴一份改改)

https://www.workerman.net/a/1822

借楼问下,我用得腾讯云提供的 deepseek 接口,然后如果需要让webman ai的deepseek模型支持解读 pdf word 图片啥的文档上传,我需要一一去实现什么?

对,要自己实现

可以接入本地部署的DeepSeek么?

可以,很简单,看教程 https://www.workerman.net/q/13796

加深度思考功能是需要自己开发吗

深度思考已经支持了

老大果然强

派欧算力云的R1好像用不了,一直不返回数据

能用,你填写错了,用这个配置

模型:

API:

可以了谢谢,没注意看